|

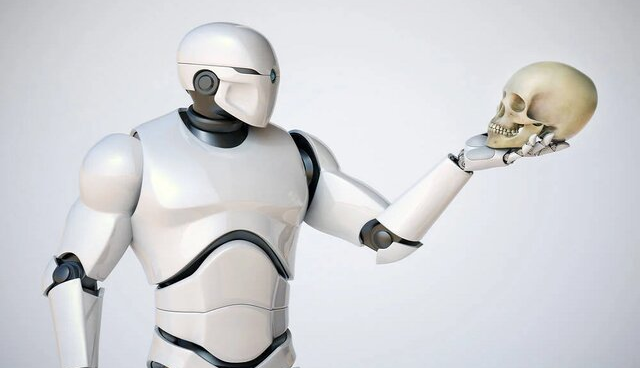

سپردن کنترل رباتها به هوش مصنوعی به همان بدی است که فکرش را میکنید!

دوشنبه 28 آبان 1403 - 17:15:43

|

|

نسیم گیلان - ایسنا /ایزاک آسیموف(Isaac Asimov)، نویسنده داستانهای علمی و تخیلی سه قانون رباتیک را مطرح میکند که شما هرگز آنها را از روی رفتارهای رباتهای امروزی یا سازندگان آنها متوجه نخواهید شد.

قانون اول این است که «ربات ممکن است به انسان آسیب نرساند یا از طریق بیعملی باعث شود که انسان آسیب ببیند»، اگرچه این قابل ستایش است، اما از 77 تصادف مرتبط با ربات بین سالهای 2015 تا 2022 جلوگیری نکرده است که بسیاری از آنها منجر به قطع انگشت و شکستگی سر و بدن شدهاند. همچنین از مرگ و میر ناشی از خودران شدن خودروها و تاکسیهای رباتیک نیز جلوگیری نکرده است.

به نقل از رجیستر، قانون دوم، این است که «ربات باید از دستوراتی که توسط انسانها داده میشود اطاعت کند، مگر در مواردی که چنین دستوراتی با قانون اول در تضاد باشد» که این به نظر مشکلسازتر میرسد. تنها نظامیان در سراسر جهان نیستند که علاقه زیادی به رباتهایی دارند که قادر به نقض قانون اول هستند. قانون دوم خیلی مبهم است و نمیتواند بین درخواستهای مجاز و غیرمجاز تمایز قائل شود.

به نظر میرسد که اگر رباتهای خود را با ریاضیات بُرداری پر کنید که به طور تعبیری هوش مصنوعی نامیده میشود، درخواستهای غیرمجاز یک مشکل واقعی ایجاد میکنند. قانون سومی نیز وجود دارد که ما نگران آن نیستیم: ربات باید از وجود خود محافظت کند تا زمانی که چنین محافظتی با قانون اول یا دوم در تضاد نباشد.

اشتیاق جدید به مدلهای زبانی بزرگ، ناگزیر منجر به این شده است که رباتسازان این مدلهای زبانی بزرگ را به رباتها بیافزایند، تا آنها بتوانند به دستورالعملهای گفتاری یا نوشتاری پاسخ دهند. برای مثال، سازنده ربات بوستون داینامیکس(Boston Dynamics)، ربات اسپات(Spot) خود را با چت جیپیتی(ChatGPT) ادغام کرده است.

از آنجایی که مدلهای زبانی بزرگ به طور گستردهای در برابر قفل شکنی آسیبپذیر شناخته شدهاند، اینکه رباتهایی که توسط مدلهای زبانی کنترل میشوند نیز ممکن است در برابر قفل شکنی آسیبپذیر باشند، دور از تصور نیست. قفل شکنی به فرآیندی گفته میشود که در آن اعلانهای با دقت ساخته شده، یک مدل و برنامهی متصل به آن را فریب میدهند تا برخلاف میل سازندگانشان عمل کند.

مدلهای زبانی بزرگ با آموزش دیدن بر روی مقادیر انبوه داده ساخته میشوند و از آنها برای پیشبینی در پاسخ به یک پیام متنی یا تصاویر یا صدا برای مدلهای چندوجهی استفاده میکنند. از آنجایی که محتوای ناخوشایند زیادی در مجموعههای آموزشی وجود دارد، مدلهای آموزشدیده بر روی این دادهها بهگونهای تنظیم میشوند که آنها را از انتشار محتوای مضر در صورت تقاضا بازدارد. در حالت ایدهآل، مدلهای زبانی بزرگ قرار است برای به حداقل رساندن آسیبهای احتمالی «هم تراز» شوند. آنها ممکن است در مورد شیمی عوامل عصبی بدانند اما قرار نیست آن را مطرح کنند.

اما با تلاش کافی میتوان این مکانیسمهای ایمنی را دور زد، فرآیندی که گفتیم به نام قفل شکنی شناخته میشود. کسانی که کار آکادمیک روی مدلهای هوش مصنوعی انجام میدهند اذعان دارند که هیچ مدل زبانی از حملات قفل شکنی کاملا در امان نیست.

بدیهی است که هیچ رباتی که از یک مدل زبانی دستور میگیرد نیز وجود ندارد که در برابر قفل شکنی مقاوم باشد. محققان دانشگاه پنسیلوانیا الگوریتمی به نام RoboPAIR برای قفل شکنی رباتهای تحت کنترل مدلهای زبانی بزرگ ابداع کردهاند.

ممکن است بپرسید، چرا کسی باید یک ربات را به یک مدل زبانی بزرگ متصل کند، با توجه به اینکه مدلها بسیار ناامن و خطاپذیر هستند؟

این سوال خوبی است اما پاسخی برای آن وجود ندارد. در حال حاضر باید بپذیریم که رباتها به مدلهای زبانی مجهز میشوند.

الکساندر روبی(Alexander Robey)، زاخاری راویچندران (Zachary Ravichandran)، ویجی کومار (Vijay Kumar)، حامد حسنی و جورج پاپاسT محققان دانشگاه پنسیلوانیا تصمیم گرفتند تا ببینند آیا رباتهایی که دارای مغز مجهز به مدل زبانی بزرگ هستند را میتوان متقاعد کرد که از دستوراتی که نباید، پیروی کنند یا خیر.

معلوم شد که میتوان این کار را کرد. آنها در مقاله خود توضیح میدهند: نتایج ما برای اولین بار نشان میدهد که خطرات مدلهای زبانی بزرگ که دچار قفل شکنی شدهاند بسیار فراتر از تولید متن است، با توجه به این احتمال که چنین رباتهایی میتوانند در دنیای واقعی آسیب فیزیکی ایجاد کنند. در واقع، نتایج ما نشان دهنده اولین قفل شکنی موفقیت آمیز یک سیستم رباتیک تجاری موجود است.

بنابراین به نظر میرسد که متصل کردن هوش مصنوعی و مدلهای زبانی بزرگ به رباتها برای کنترل آنها اگر در مسیر اشتباهی قرار گیرد میتواند برای انسانها فاجعهبار باشد.

http://www.gilan-online.ir/fa/News/788942/سپردن-کنترل-رباتها-به-هوش-مصنوعی-به-همان-بدی-است-که-فکرش-را-میکنید!

|